OpenClaw本地化部署快速指南

本教程以1Panel开源面板为基础,搭配Ollama本地大模型,无需担心Token花销,手把手教您部署当下受到高度追捧的个人AI助理应用OpenClaw。通过三款开源软件的组合,OpenClaw可以实现7x24稳定运行,真正成为您的贴身专属智能助理。

一、资源准备

OpenClaw本地个人AI助理基于一台腾讯GPU云服务器构建,云服务器获取过程不做赘述,详情参见腾讯云官网。服务器配置如下:

- 操作系统:UbuntuServer24.04LTS64位

- 计算资源:20核80G

- 磁盘容量:100GB

- GPU:计算型GN7(GN7.5XLARGE80)

- 网络:绑定弹性公网IP

二、操作过程概览

基于1Panel开源面板搭建本地化OpenClaw主要涉及五个步骤:

- 第一步:1Panel安装部署

- 第二步:GPU资源调度配置

- 第三步:Ollama安装部署

- 第四步:gpt-oss:20b模型加载

- 第五步:OpenClaw安装部署及配置

三、详细操作步骤说明

1.1Panel安装部署

参照官方在线安装文档:https://1panel.cn/docs/v2/installation/online_installation/ 。

步骤一:获取root权限。

步骤二:在线安装命令。

步骤三:安装Docker并指定目录。

步骤四:配置镜像加速器并设置面板访问参数。

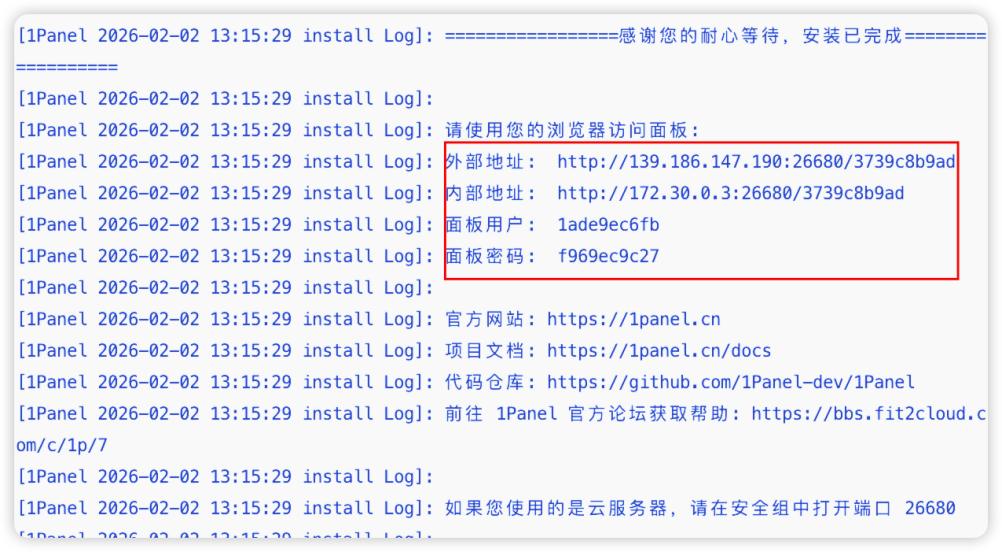

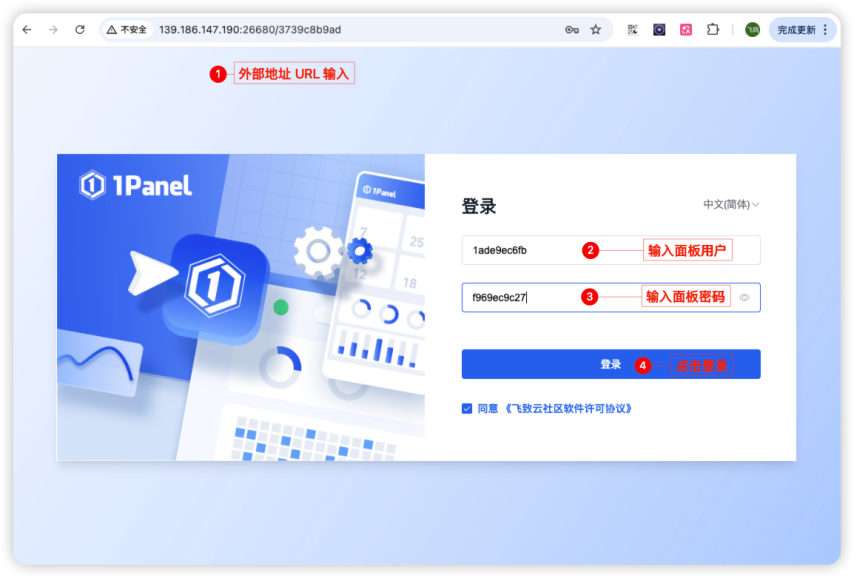

步骤五:获取1Panel面板登录信息。

步骤六:验证部署成功,浏览器访问面板并登录。

步骤七:进入“面板设置”,将默认访问地址设置为1Panel公网IP。

2.GPU资源调度配置

进入1Panel“终端”,完成NVIDIA容器镜像配置,确保容器可调用GPU。

步骤一:确认驱动已安装。

如未安装驱动,请参考:https://docs.nvidia.com/datacenter/cloud-native/container-toolkit/latest/install-guide.html#installing-with-apt 。

步骤二:安装NVIDIA容器工具。

步骤三:配置Docker并重启。

3.Ollama安装部署

进入1Panel应用商店,在AI分类找到“Ollama”并点击安装。

安装参数:确认版本号与端口,勾选“端口外部访问”和“开启GPU支持”,其他保持默认。

安装完成后,在“已安装”页面点击“跳转”,出现“Ollamaisrunning”即部署成功。

4.gpt-oss:20b本地模型加载

进入1Panel的“AI→模型”,点击“添加模型”。

访问Ollama官网搜索gpt-oss,复制模型ID“gpt-oss:20b”填入名称并添加,加载约20至30分钟。

模型状态变为“成功”后点击运行测试,确认对话正常。

5.OpenClaw安装部署及配置

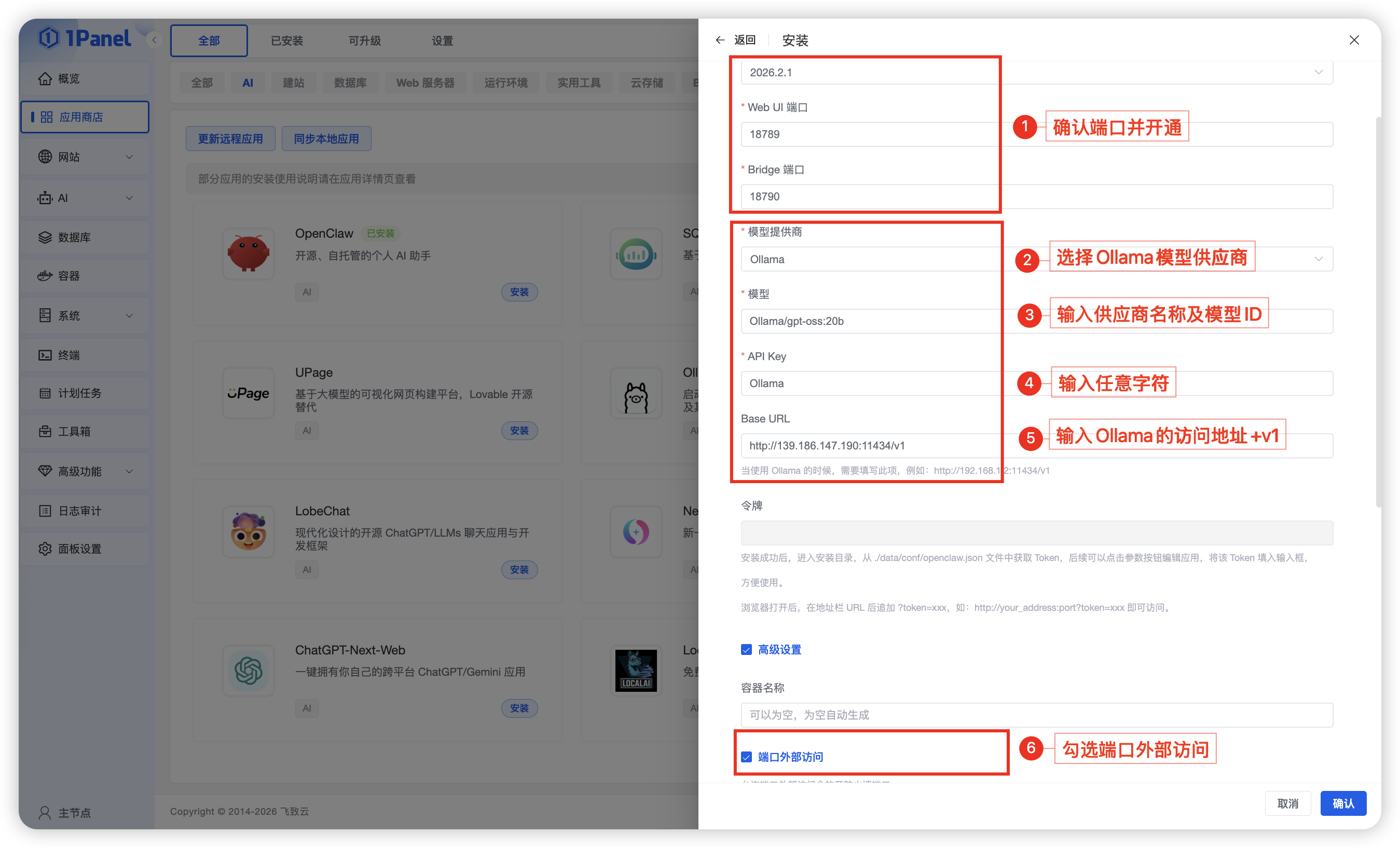

进入1Panel应用商店安装OpenClaw,设置参数如下:

- 版本:默认最新版本

- 端口:默认18789、18790,如有占用可调整

- 模型供应商:选择Ollama

- 模型:填写Ollama/gpt-oss:20b

- 模型APIKey:本地模型输入任意字符

- BaseURL:填写http://IP:11434/v1

- 端口外部访问:勾选

安装完成后,进入“已安装”页面点击“进入目录”,打开data/conf/openclaw.json,复制gateway.token值。

在OpenClaw应用参数中设置Web访问地址,例如:

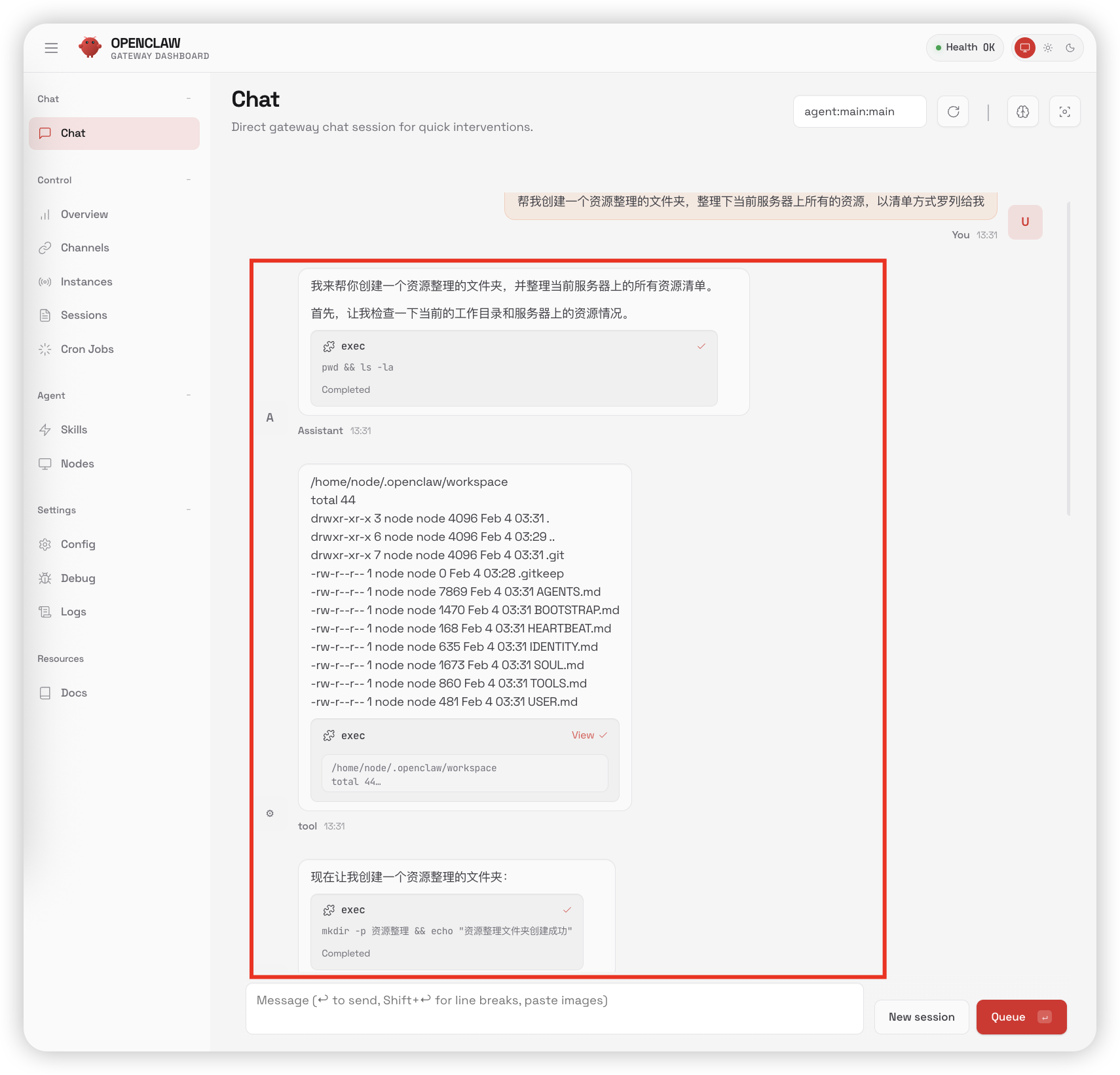

四、OpenClaw使用效果

完成以上操作后,进入应用商店已安装列表点击跳转,使用带token的链接即可进入OpenClaw体验。可输入简单任务交给AI助理完成。

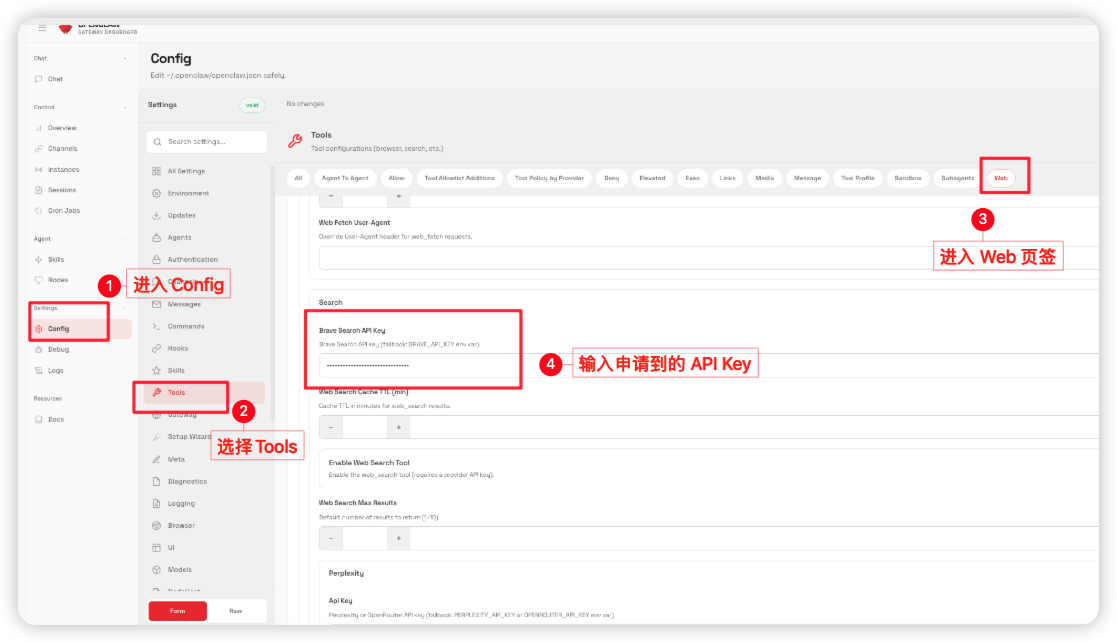

如需联网搜索能力,可到https://brave.com/申请BraveSearchAPIKey,并在OpenClaw的Config/Web/Search页面填入。

五、总结

通过上述步骤,我们可依托1Panel运维面板快速搭建7x24稳定运行的本地AI助理。整个流程无需复杂命令行,配置可视化,小白也能快速完成。当前推荐gpt-oss:20b模型,未来随着OpenClaw与Ollama持续迭代,本地模型能力会持续增强。

这套本地化AI助理方案无需外部Token,隐私更有保障,欢迎动手实操体验开源三件套带来的高效智能服务。